DeepSeek-dən istifadə edənlərin NƏZƏRİNƏ - Bu yolla aldadıla bilərsiniz

App Store-da "DeepSeek" adlı süni intellekt çat-botunun saxta versiyaları yayılmağa başlayıb.

BAKU.WS-in məlumatına görə, bu tətbiqlər vizual olaraq orijinala bənzəyir və istifadəçiləri əlavə funksiyalar vəd edərək cəlb etməyə çalışır.

"Apple"nin moderasiya sisteminə baxmayaraq, bu proqramlar yenə də istifadəçilər üçün potensial təhlükə yaradır.

Təhlükə nədən ibarətdir?

Yanvar ayının sonundan etibarən Çin istehsalı olan "DeepSeek" çat-botunun populyarlığının artması ilə saxta tətbiqlər də App Store-da peyda olub. Onlar DeepSeek-ə bənzər adlardan və dizaynlardan istifadə edərək istifadəçilərin etibarını qazanmağa çalışırlar. Bu tətbiqlər Apple-ın təsdiqindən keçsə də, kibertəhlükəsizlik mütəxəssisləri onlardan ehtiyatlı olmağı tövsiyə edirlər.

"Positive Technologies" şirkətinin araşdırma qrupunun analitiki Roman Reznikov bu üsulların adi bir hal olduğunu bildirib: "Kibercinayətkarlar hər zaman məşhur mövzulardan istifadə edərək saxta tətbiqlər yaradırlar".

Onun sözlərinə görə, bu cür tətbiqlər App Store-un yoxlamalarından keçsə də, sonradan zərərli dəyişikliklər edilə bilər. Həmçinin bəzi tətbiqlər qanuni klon kimi fəaliyyət göstərərək istifadəçilərə baha başa gələn abunəliklər təklif edə bilər.

İstifadəçilər hansı risklərlə üzləşə bilərlər?

"Digital Risk Protection" (F.A.C.C.T.) şirkətinin aparıcı analitiki Yevgeni Yeqorov qeyd edib ki, belə saxta tətbiqlər istifadəçi məlumatlarını üçüncü şəxslərə ötürə bilər:

"Bu tətbiqlər istifadəçilərin daxil etdiyi məlumatları toplayaraq fırıldaqçılara göndərə bilər. Həmçinin, içərisində fişinq formaları gizlədilərək bank kartı və hesab məlumatlarını oğurlamaq üçün istifadə edilə bilər"

"Kasperski Laboratoriyası" kibertəhlükəsizlik eksperti Sergey Puzan isə bildirib ki, o, App Store-da olan "DeepSeek" klonlarını araşdırıb və hazırda bu tətbiqlərdə zərərli kod tapmayıb. Amma bu, gələcəkdə təhlükənin olmayacağı anlamına gəlmir:

"Hətta rəsmi mağazalara fişinq və ya saxta tətbiqlər daxil ola bilər. İstifadəçilər reytinqlərə və rəylərə baxmalı, tətbiqləri yalnız rəsmi mənbələrdən yükləməlidir."

Saxta tətbiqlər işləməyə bilər və ya bahalı ola bilər

Saxta "DeepSeek" tətbiqləri pulsuz və ya aşağı qiymətə təqdim olunsa da, işləməsi üçün daxili ödənişlər tələb edə bilər. Yegorov bu məsələyə belə izah verib:

"İstifadəçilər yüksək məbləğdə abunə haqqı ödəsələr belə, tətbiqin işləyəcəyinə heç bir zəmanət yoxdur. Belə tətbiqlər qısa müddət ərzində App Store-dan silinə bilər."

Roman Reznikov isə əlavə edib ki, belə tətbiqlər yalnız pul oğurlamaqla kifayətlənmir.

Hədəfə bunlar çevrilir:

Şəxsi məlumatlar, parollar və bank kartı məlumatları oğurlana bilər

Kompüter resursları kriptovalyuta sahəsində istifadə edilə bilər

İstifadəçi zərərli reklam və ya dezinformasiyaya məruz qala bilər.

Ekspertlər bildirirlər ki, "DeepSeek" klonlarının yayılması bu çat-botun rəsmi şirkətinin onları nə dərəcədə tez aşkarlayıb silməsindən asılıdır.

Bundan əlavə, Reznikov vurğulayır ki, saxta tətbiqlər yalnız texnologiya sahəsinə aid deyil. Kibercinayətkarlar yeni texnologiyalar, idman hadisələri və hətta sosial mövzular ətrafında da bu cür saxtakarlıqlar həyata keçirirlər.

O, istifadəçilərə tövsiyə edib:

Tətbiqləri yalnız rəsmi mənbələrdən yükləyin

Reytinq və rəyləri yoxlayın

Tətbiqin icazələrini diqqətlə izləyin.

Sergey Puzan isə əlavə edib ki, DeepSeek açıq kodlu böyük dil modelləri yaradır:

"Bu isə o deməkdir ki, istənilən şəxs bu texnologiyadan istifadə edərək öz çat-botunu yarada bilər. Ona görə də istifadəçilər hansı tətbiqdən istifadə etdiklərinə diqqət etməli və məxfi məlumatlarını hər hansı bir çat-botla paylaşmamalıdırlar.

İnsanlar unutmamalıdırlar ki, süni intellekt texnologiyalarının istifadəsi zamanı bulud sistemlərinə məlumat göndərilir. Bulud xidmətlərindən məlumat sızmaları halları əvvəllər də baş verib".

Oxşar xəbərlər

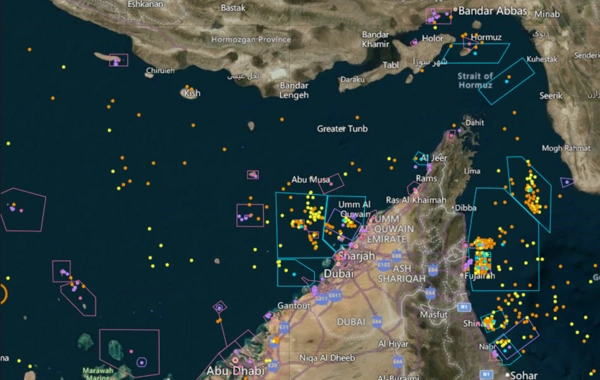

Hörmüz boğazı bağlı qalsa, dünya neft bazarını "fəlakətli" nəticələr gözləyə bilər

Hörmüz boğazının bağlanması səbəbindən yaranan fasilə davam edərsə, bu, dünya neft bazarları üçün "fəlakətli" nəticələrə səbəb ola bilər. BAKU.WS xəbər verir ki...

Azərbaycanca

Azərbaycanca  По-русски

По-русски  English

English